最佳免费网络爬虫工具有哪些?你是否正在寻找工具来提高你的 SEO 排名、曝光率和转化率?为此,你需要一个网络爬虫工具。网络爬虫是一种扫描互联网的计算机程序。网络蜘蛛、网络数据提取软件和网站抓取程序是互联网网络爬虫技术的示例。它也被称为蜘蛛机器人或蜘蛛。今天,我们将看看一些免费的网络爬虫工具可供下载。

25 个最好的免费网络爬虫工具合集

网络爬虫工具为数据挖掘和分析提供了丰富的信息。它的主要目的是索引互联网上的网页。它可以检测断开的链接、重复的内容和丢失的页面标题,并识别严重的 SEO 问题。抓取在线数据可能会以多种方式使你的业务受益。

一些网络爬虫应用程序可以正确地从任何网站 URL 爬取数据。

这些程序可帮助你改进网站的结构,以便搜索引擎能够理解它并提高你的排名。

在我们的顶级工具列表中,我们编制了一份网络爬虫工具免费下载列表及其功能和成本供你选择。该列表还包括应付申请。

1.OpenSearchServer

常用的免费网络爬虫工具推荐:tutorials/crawling_a_website.md" class=" wrap external" target="_blank" rel="nofollow noreferrer" data-za-detail-view-id="1043" style="text-decoration-line: none; border-bottom: 1px solid rgb(128, 128, 128); cursor: pointer;">OpenSearchServer是一个免费的网络爬虫,在 Internet 上拥有最高评级。可用的最佳替代方案之一。

它是一个完全集成的解决方案。

Open Search Server 是一个免费和开源的网络爬虫和搜索引擎。

这是一个一站式且具有成本效益的解决方案。

它具有一套全面的搜索功能,并且可以构建你自己的索引策略。

爬虫几乎可以索引任何东西。

有全文、布尔和语音搜索可供选择。

你可以从17 种不同的语言中进行选择。

进行自动分类。

你可以为经常发生的事情制定时间表。

2. Spinn3r

最佳免费网络爬虫工具下载:Spinn3r网络爬虫程序允许你从博客、新闻、社交网站、RSS 提要和 ATOM 提要中完全提取内容。

它带有一个闪电般快速的 API,可以处理95%的索引工作。

此网络爬虫应用程序包含高级垃圾邮件保护,可删除垃圾邮件和不恰当的语言使用,从而提高数据安全性。

网络爬虫不断地在网络上搜索来自众多来源的更新,为你呈现实时内容。

它以与 Google 相同的方式索引内容,并将提取的数据保存为 JSON 文件。

Parser API 允许你快速解析和管理任意 Web URL 的信息。

Firehose API 专为大规模访问大量数据而设计。

简单的 HTTP 标头用于验证 Spinn3r 的所有 API。

这是一个免费下载的网络爬虫工具。

分类器 API 使开发人员能够传输要由我们的机器学习技术标记的文本(或 URL)。

3. http://Import.io

哪个免费网络爬虫工具最好用?Import.io允许你在几分钟内抓取数百万个网页,并根据你的需求构建 1000 多个 API,而无需编写任何代码。

它现在可以通过编程方式进行操作,并且现在可以自动检索数据。

只需按一下按钮,即可从许多页面中提取数据。

它可以自动识别分页列表,也可以点击下一页。

只需点击几下,你就可以将在线数据整合到你的应用程序或网站中。

通过使用页码和类别名称等模式,在几秒钟内创建你需要的所有 URL。

http://Import.io 可以直接演示如何从页面中提取数据。只需从数据集中选择一列,然后指向页面上吸引你眼球的内容。

你可能会在他们的网站上收到报价。

列表页面上的链接指向包含更多信息的详细页面。

你可以使用 http://Import.io 加入它们以一次从详细信息页面获取所有数据。

4. BUBIING

BUbiNG是下一代网络爬虫工具,是作者使用 UbiCrawler 的经验和对该主题十年研究的结晶。

单个代理每秒可以抓取数千页,同时遵守严格的礼貌标准,包括主机和基于 IP 的。

它的作业分配建立在现代高速协议之上,以提供非常高的吞吐量,这与早期依赖批处理技术的开源分布式爬虫不同。

它使用剥离页面的指纹来检测近似重复。

BUbiNG 是一个完全分布式的开源 Java 爬虫。

它有很多并行性。

有很多人使用这个产品。

很快。

它可以实现大规模爬取。

5.GNU Wget

GNU Wget是一个免费的网络爬虫工具,可以免费下载,它是一个用 C 语言编写的开源软件程序,允许你通过HTTP、HTTPS、FTP 和 FTPS获取文件。

此应用程序最独特的方面之一是能够以各种语言创建基于 NLS 的消息文件。

你可以使用REST 和 RANGE重新启动已停止的下载。

如果需要,它还可以将下载文档中的绝对链接转换为相对链接。

在文件名和镜像目录中递归使用通配符。

基于 NLS 的多种语言的消息文件。

镜像时,会评估本地文件时间戳以确定是否需要重新下载文档。

6. http://Webhose.io

Webhose.io是一款出色的网络爬虫应用程序,可让你使用跨越各种来源的各种过滤器扫描数据并提取多种语言的关键字。

该存档还允许用户查看以前的数据。

此外,http://webhose.io 的爬取数据发现支持多达80 种语言。

所有被泄露的个人身份信息都可以在一个地方找到。

调查暗网和消息传递应用程序是否存在网络威胁。

XML、JSON 和 RSS 格式也可用于抓取的数据。

你可能会在他们的网站上收到报价。

用户可以简单地索引和搜索 http://Webhose.io 上的结构化数据。

在所有语言中,它都可以监控和分析媒体渠道。

可以在留言板和论坛上关注讨论。

它允许你跟踪来自网络各地的关键博客文章。

7. Norconex

Norconex是寻找开源网络爬虫应用程序的企业的绝佳资源。

这个功能齐全的收集器可以使用或集成到你的程序中。

它也可能采用页面的特色图像。

Norconex 使你能够抓取任何网站的内容。

可以使用任何操作系统。

该网络爬虫软件可以在单个平均容量服务器上爬取数百万个页面。

它还包括一组用于修改内容和元数据的工具。

获取你当前正在处理的文档的元数据。

支持JavaScript 呈现的页面。

它可以检测多种语言。

它支持翻译帮助。

你爬行的速度可能会改变。

已被修改或删除的文档被识别。

这是一个完全免费的网络爬虫程序。

8. http://Dexi.io

Dexi.io是一个基于浏览器的网络爬虫应用程序,可让你从任何网站抓取信息。

提取器、爬行器和管道是你可以用来进行刮削操作的三种机器人。

使用 Delta 报告预测市场发展。

你收集的数据将在 http://Dexi.io 的服务器上保存两周,然后存档,或者你可以立即将提取的数据导出为JSON 或 CSV 文件。

你可能会在他们的网站上收到报价。

提供专业服务,例如质量保证和持续维护。

它提供商业服务来帮助你满足你的实时数据需求。

可以跟踪无限数量的 SKU/产品的库存和定价。

它允许你使用实时仪表板和完整的产品分析来集成数据。

它可以帮助你准备和清洗基于 Web 的有组织且随时可用的产品数据。

9. Zyte

最好的免费网络爬虫工具合集:Zyte是一款基于云的数据提取工具,可帮助数以万计的开发人员定位关键信息。它也是最好的免费网络爬虫应用程序之一。

用户可以在不知道任何编码的情况下使用其开源视觉抓取应用程序抓取网页。

Crawlera是 Zyte 使用的复杂代理旋转器,它允许用户轻松爬取大型或受 bot 保护的网站,同时规避 bot 对策。

你的在线信息会按时并始终如一地交付。因此,你可以专注于获取数据,而不是管理代理。

由于智能浏览器功能和渲染,现在可以轻松管理针对浏览器层的反机器人。

在他们的网站上,你可能会得到报价。

用户可以使用简单的 HTTP API 从众多 IP 和区域爬取,无需代理维护。

它可以帮助你产生现金,同时通过获取你需要的信息来节省时间。

它允许你大规模提取 Web 数据,同时节省编码和蜘蛛维护时间。

10. Apache Nutch

最佳免费网络爬虫工具有哪些?Apache Nutch毫无疑问在最伟大的开源网络爬虫应用程序列表中名列前茅。

它可以在一台机器上运行。但是,它在 Hadoop 集群上表现最好。

对于身份验证,采用NTLM 协议。

它有一个分布式文件系统(通过 Hadoop)。

它是一个著名的开源在线数据提取软件项目,具有数据挖掘的适应性和可扩展性。

世界各地的许多数据分析师、科学家、应用程序开发人员和网络文本挖掘专家都在使用它。

这是一个基于 Java 的跨平台解决方案。

默认情况下,获取和解析是独立完成的。

使用XPath 和命名空间映射数据。

它包含一个链接图数据库。

11. VisualScraper

最佳免费网络爬虫工具下载:VisualScraper是另一个出色的非编码网络爬虫,用于从 Internet 中提取数据。

它提供了一个简单的点击式用户界面。

它还提供在线抓取服务,例如数据传播和软件提取器的构建。

它也密切关注你的竞争对手。

用户可以安排他们的项目在特定时间运行,或者使用 Visual Scraper 每隔一分钟、一天、一周、一个月和一年重复该顺序。

它更便宜,也更有效。

甚至没有密码可以说话。

这是一个完全免费的网络爬虫程序。

实时数据可以从多个网页中提取并保存为CSV、XML、JSON 或 SQL 文件。

用户可能会使用它来定期提取新闻、更新和论坛帖子。

数据是100% 准确和定制的。

12. WebSphinx

哪个免费网络爬虫工具最好用?WebSphinx是一款出色的个人免费网络爬虫应用程序,易于设置和使用。

它专为希望自动扫描 Internet 有限部分的复杂网络用户和 Java 程序员而设计。

这个在线数据提取解决方案包括一个 Java 类库和一个交互式编程环境。

页面可以连接起来形成一个可以浏览或打印的文档。

从一系列页面中提取符合给定模式的所有文本。

多亏了这个包,网络爬虫现在可以用 Java 编写。

Crawler Workbench 和WebSPHINX类库都包含在 WebSphinx 中。

Crawler Workbench 是一个图形用户界面,允许你自定义和操作网络爬虫。

一个图表可以由一组网页组成。

将页面保存到本地驱动器以供离线阅读。

13. OutWit Hub

常用的免费网络爬虫工具推荐:OutWit Hub平台由一个内核组成,该内核具有广泛的数据识别和提取功能库,可以在其上创建无数不同的应用程序,每个应用程序都利用内核的功能。

此网络爬虫应用程序可以扫描站点并以可访问的方式保存它发现的数据。

它是一种多功能收割机,具有尽可能多的功能以满足各种要求。

Hub 已经存在了很长时间。

对于知道如何编码但认识到 PHP 并不总是提取数据的理想选择的非技术用户和 IT 专业人员来说,它已经发展成为一个有用且多样化的平台。

OutWit Hub 提供单一界面,可根据你的需求抓取适度或大量数据。

它使你能够直接从浏览器中抓取任何网页,并构建自动代理来抓取数据并根据你的要求进行准备。

你可能会在他们的网站上收到报价。

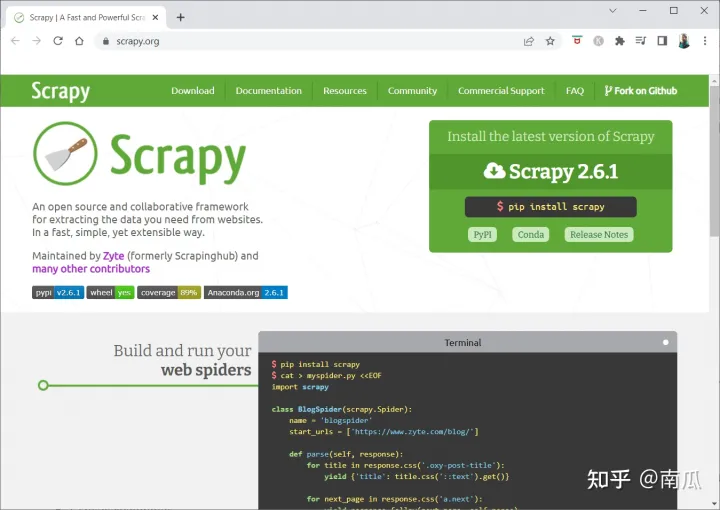

14. Scrapy

Scrapy是一个 Python 在线抓取框架,用于构建可扩展的网络爬虫。

它是一个完整的网络爬虫框架,可以处理使网络爬虫难以创建的所有特征,例如代理中间件和查询问题。

你可以编写提取数据的规则,然后让 Scrapy 处理其余部分。

无需修改内核即可轻松添加新功能,因为它就是这样设计的。

它是一个基于 Python 的程序,可在Linux、Windows、Mac OS X 和 BSD 系统上运行。

这是一个完全免费的实用程序。

它的库为程序员提供了一个现成的结构,用于自定义网络爬虫并从网络中大规模提取数据。

15. Mozenda

Mozenda也是最好的免费网络爬虫应用程序。它是一个面向业务的基于云的自助式网页抓取程序。Mozenda 已抓取超过70 亿页,并在世界各地拥有企业客户。

Mozenda 的网络抓取技术消除了对脚本的要求和工程师的雇用。

它将数据收集速度提高了五倍。

你可以使用 Mozenda 的点击功能从网站上抓取文本、文件、图像和 PDF 信息。

通过组织数据文件,你可以为发布做好准备。

你可以使用 Mozeda 的 API 直接导出到 TSV、CSV、XML、XLSX 或 JSON。

你可以使用 Mozenda 复杂的数据整理来组织你的信息,以便你做出重要的决定。

你可以使用 Mozenda 合作伙伴的平台之一来集成数据或在几个平台中建立自定义数据集成。

16. Cyotek Webcopy

Cyotek Webcopy是一款免费的网络爬虫工具,可让你自动将网站内容下载到本地设备。

所选网站的内容将被扫描和下载。

你可以选择要克隆网站的哪些部分以及如何使用其复杂的结构。

新的本地路由会将链接重定向到样式表、图片和其他页面等网站资源。

它将查看网站的 HTML 标记并尝试查找任何连接的资源,例如其他网站、照片、视频、文件下载等。

它可能会爬取网站并下载它所看到的任何内容,以制作可接受的原始副本。

17. Common Crawl

Common Crawl适用于任何有兴趣探索和分析数据以获取有用见解的人。

这是一家501(c)(3) 非营利组织,依靠捐款来正常运营。

任何希望使用 Common Crawl 的人都可以在不花任何钱或造成问题的情况下这样做。

Common Crawl 是一个可用于教学、研究和分析的语料库。

如果你没有任何技术技能来了解其他人利用 Common Crawl 数据取得的非凡发现,那么你应该阅读这些文章。

教师可以使用这些工具来教授数据分析。

18. Semrush

Semrush是一个网站爬虫应用程序,可检查你网站的页面和结构是否存在技术 SEO 问题。解决这些问题可以帮助你增强搜索结果。

它有用于搜索引擎优化、市场研究、社交媒体营销和广告的工具。

它有一个用户友好的用户界面。

将检查元数据、HTTP/HTTPS、指令、状态代码、重复内容、页面响应速度、内部链接、图像大小、结构化数据和其他元素。

它使你可以快速简单地审核你的网站。

它有助于分析日志文件。

该程序提供了一个仪表板,可让你轻松查看网站问题。

19. Sitechecker.pro

哪个免费网络爬虫工具最好用?Sitechecker.pro是另一个最好的免费网络爬虫应用程序。它是网站的 SEO 检查器,可帮助你提高 SEO 排名。

你可以轻松地可视化网页的结构。

它创建了一个页面上的 SEO 审计报告,客户可以通过电子邮件获得该报告。

这个网络爬虫工具可以查看你网站的内部和外部链接。

它可以帮助你确定网站的速度。

你还可以使用 Sitechecker.pro检查登录页面上的索引问题。

它可以帮助你防御黑客攻击。

20.Webharvy

最佳免费网络爬虫工具有哪些?Webharvy是一个网页抓取工具,具有简单的点击式界面。它是为那些不知道如何编码的人设计的。

许可证的起价为139 美元。

你将使用 WebHarvy 的内置浏览器加载在线站点并使用鼠标单击选择要抓取的数据。

它可以自动从网站上抓取文本、照片、URL 和电子邮件,并以各种格式保存。

代理服务器或 VPN可用于访问目标网站。

抓取数据不需要创建任何程序或应用程序。

你可以通过使用代理服务器或 VPN 访问目标网站,匿名抓取并防止网页抓取软件被网络服务器禁止。

WebHarvy 自动识别网站中的数据模式。

如果你需要从网页中抓取对象列表,则无需执行任何其他操作。

21. NetSpeak Spider

最佳免费网络爬虫工具下载:NetSpeak Spider是一款桌面网络爬虫应用,用于日常SEO 审计,快速发现问题,进行系统分析,抓取网页。

这个网络爬虫应用程序擅长评估大型网页,同时最大限度地减少 RAM 使用。

CSV 文件可以很容易地从网络爬取数据中导入和导出。

只需单击几下,你就可以识别这些以及数百个严重的其他网站 SEO 问题。

该工具将帮助你评估网站的页面优化,包括状态代码、抓取和索引说明、网站结构和重定向等。

来自Google Analytics 和 Yandex的数据可能会被导出。

为你的网站页面、流量、转化、目标甚至电子商务设置考虑数据范围、设备类型和细分。

它的每月订阅起价为 21 美元。

SEO 爬虫将检测到损坏的链接和照片,以及重复的材料,例如页面、文本、重复的标题和元描述标签以及 H1。

22.UiPath

最好的免费网络爬虫工具合集:UiPath是一个网络爬虫在线抓取工具,可让你自动化机器人程序。它为大多数第三方程序自动抓取在线和桌面数据。

你可以在 Windows 上安装机器人过程自动化应用程序。

它可以从许多网页中以表格和基于模式的形式提取数据。

UiPath 可以直接进行额外的爬取。

报告会跟踪你的机器人,以便你随时参考文档。

如果你标准化你的实践,你的结果将更加有效和成功。

每月订阅起价为 420 美元。

Marketplace 的200 多个现成组件为你的团队提供更多时间和更少的时间。

UiPath 机器人通过遵循满足你需求的确切方法来提高合规性。

公司可以通过优化流程、认识经济和提供见解来以更低的成本实现快速的数字化转型。

23. Helium Scraper

Helium Scraper是一个可视化在线数据网络爬取应用程序,当元素之间几乎没有关联时效果最佳。基本可以满足用户的爬取需求。

它不需要任何编码或配置。

清晰简单的用户界面允许你从指定列表中选择和添加活动。

在线模板也可用于专门的爬网要求。

在屏幕外,使用了几个 Chromium 网络浏览器。

增加同时浏览器的数量以获取尽可能多的数据。

定义你自己的操作或将自定义 JavaScript 用于更复杂的实例。

它可以安装在个人计算机或专用 Windows 服务器上。

它的许可证起价为 99 美元,并从那里开始上涨。

24. 80Legs

2009 年,80Legs成立,旨在让在线数据更易于访问。它是另一个最好的免费网络爬虫工具之一。最初,该公司专注于为各种客户提供网络爬虫服务。

我们广泛的网络爬虫应用程序将为你提供个性化信息。

爬取速度会根据网站流量自动调整。

你可以通过 80legs 将调查结果下载到本地环境或计算机。

只需提供一个 URL,你就可以抓取该网站。

它的每月订阅起价为每月 29 美元。

通过 SaaS,可以构建和进行网络爬虫。

它有许多服务器,可让你从各种 IP 地址查看站点。

获得对站点数据的即时访问,而不是在网络上搜索。

它有助于定制网络爬虫的构建和执行。

你可以使用此应用程序来跟踪在线趋势。

如果你愿意,你可以制作你的模板。

25. ParseHub

常用的免费网络爬虫工具推荐:ParseHub是一款出色的网络爬虫应用程序,可以从使用 AJAX、JavaScript、cookie 和其他相关技术的网站收集信息。

它的机器学习引擎可以读取、评估在线内容并将其转换为有意义的数据。

你还可以使用浏览器中的内置网络应用程序。

从数以百万计的网站获取信息是可能的。

ParseHub 将自动搜索数千个链接和单词。

数据会自动收集并存储在我们的服务器上。

每月套餐起价149 美元。

作为共享软件,你只能在 ParseHub 上构建五个公共项目。

你可以使用它来访问下拉菜单、登录网站、单击地图以及使用无限滚动、选项卡和弹出窗口管理网页。

ParseHub 的桌面客户端可用于Windows、Mac OS X 和 Linux。

你可以获取任何格式的抓取数据进行分析。

你可以建立至少20 个具有高级会员级别的私人抓取项目。

推荐本站淘宝优惠价购买喜欢的宝贝:

本文链接:https://hqyman.cn/post/3835.html 非本站原创文章欢迎转载,原创文章需保留本站地址!

休息一下~~

微信支付宝扫一扫,打赏作者吧~

微信支付宝扫一扫,打赏作者吧~