使用LM Studio快速体验大模型工具,免除Python环境及众多依赖组件的安装。可以切换不同类型的大语言模型,同时支持在windows、linux、mac等PC端部署。

1. 环境配置

本次使用的操作系统及硬件信息如下:

操作系统:windows11 23H2

CPU: intel i7-12700

MEM: 16GB

GPU: NVIDIA GeForce GTX 1650

Disk: 512GB SSD

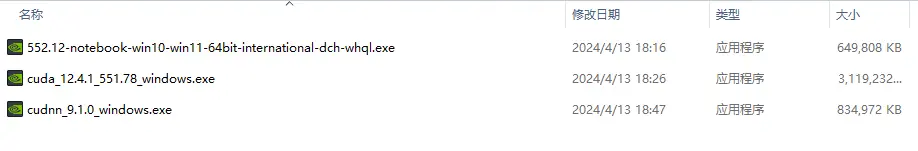

已经安装nvidia显卡驱动+cuda+cudnn,配套如下:

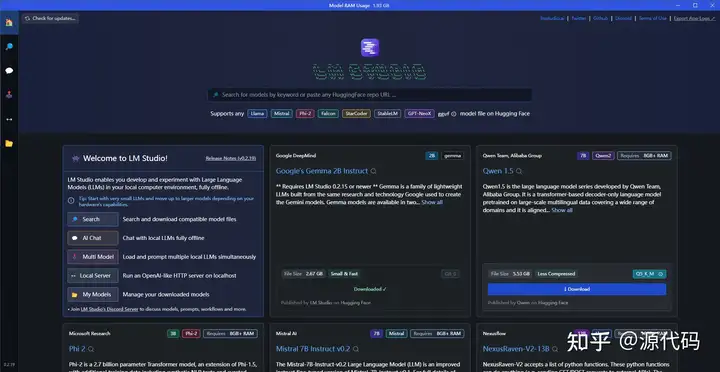

2. 安装LM Studio

访问官网,选择windows版本下载安装。

安装完成打开后的界面如下:

3. 模型配置

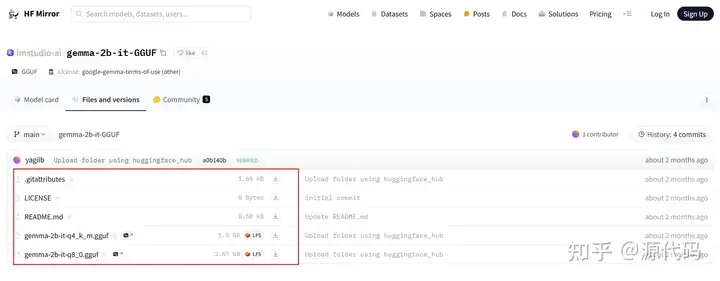

以首页推荐的谷歌deepmind出品的模型Google's Gemma 2B Instruct为例,点击搜索会跳转到huggingface官网改模型的URL:

https://huggingface.co/lmstudio-ai/gemma-2b-it-GGUF

直接使用lmstudio下载模型会失败,本文采用离线部署模式。

3.1 访问huggingface官网或镜像站点,下载模型文件

huggingface官网:

https://hf-mirror.com/lmstudio-ai/gemma-2b-it-GGUF

镜像站点:

https://hf-mirror.com/lmstudio-ai/gemma-2b-it-GGUF/tree/main

3.2 导入模型文件

下载模型文件后按照如下目录层级放置到本地路径

本地路径查询如下,LM Studio-Mymodel-show in File Explorer

4. 运行模型

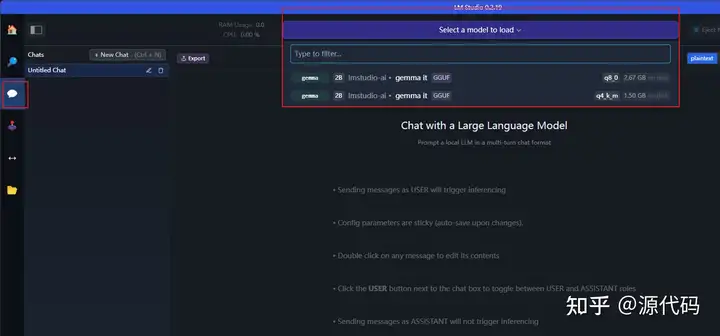

4.1 AIChat-选择模型加载

选择上述导入的模型。

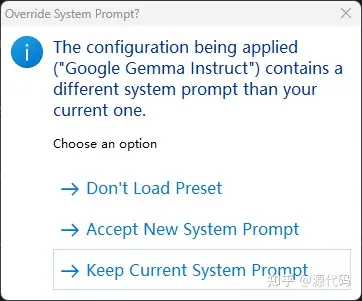

可以设置默认prompt或使用当前系统prompt:

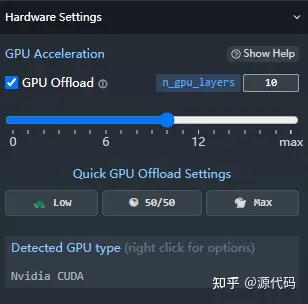

默认启用了GPU:

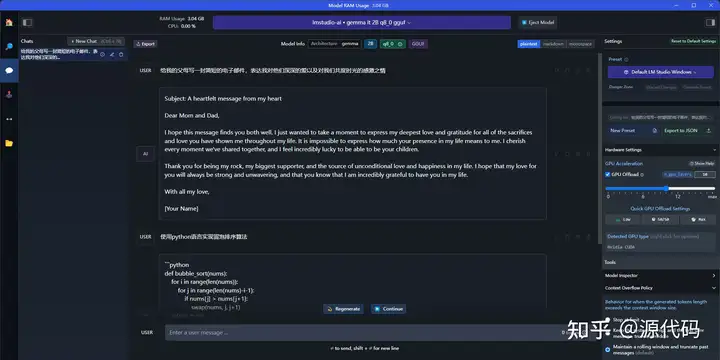

4.2 chat对话测试

模型加载完毕后即可进行对话测试:

4.3 local server

除了UI界面的chat对话使用之外,也可以在本地启动服务器,使用接口进行调试。包括curl、python等方式。

推荐本站淘宝优惠价购买喜欢的宝贝:

本文链接:https://hqyman.cn/post/6917.html 非本站原创文章欢迎转载,原创文章需保留本站地址!

休息一下~~

微信支付宝扫一扫,打赏作者吧~

微信支付宝扫一扫,打赏作者吧~