关于 DeepSeek、Ollama 和 Open-WebUI 的本地集成化部署,请参考以下三篇文章:

Rocky Linux 9 AI 系列 008 — 使用 Ollama 构建本地大模型 – Rocky Linux: https://www.rockylinux.cn/notes/building-local-large-models-with-ollama.html Rocky Linux 9 AI 系列 009 — Open-WebUI 与 Ollama 无缝集成配置指南 – Rocky Linux: https://www.rockylinux.cn/notes/olama-combines-open-webui-to-achieve-natural-language.html Rocky Linux 9 AI 系列 010 — LiteLLM 反代 Azure OpenAI – Rocky Linux: https://www.rockylinux.cn/notes/litellm-reverse-proxy-azure-openai.html

更多关于 AI 系列的参考文章,请访问:AI 系列文章: https://www.rockylinux.cn/tag/a

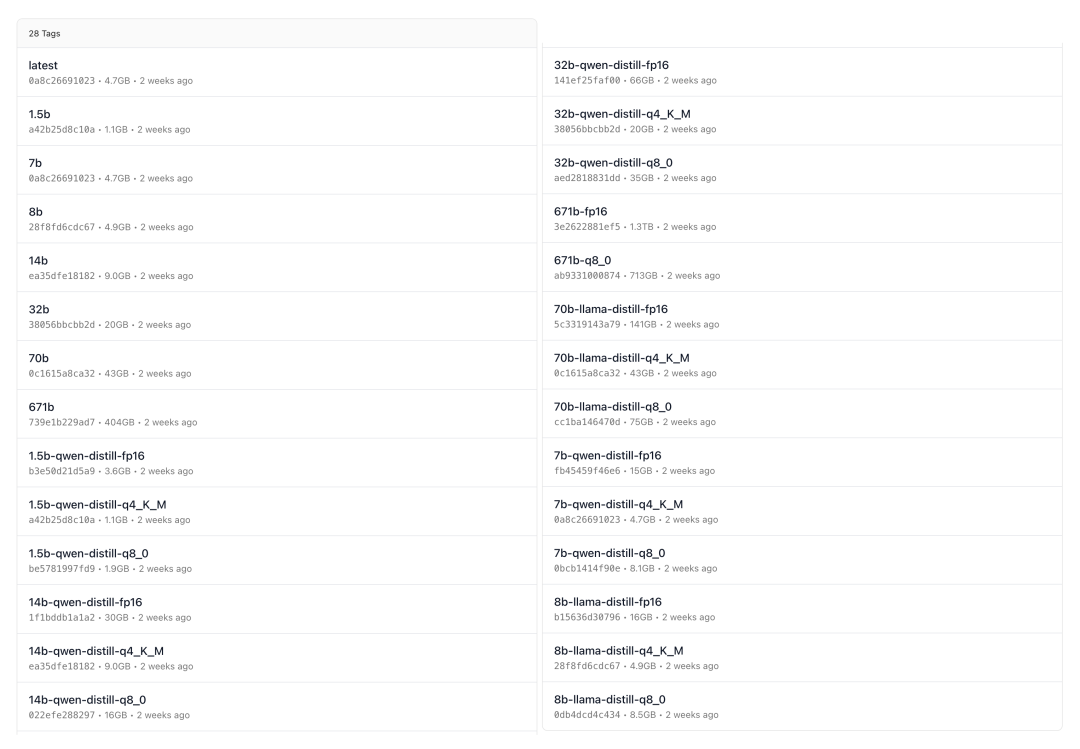

这里简单介绍一下 Ollama DeepSeek R1 模型的选择。可以通过以下链接下载:DeepSeek R1 模型下载

在下载页面,您会看到许多不同类型的模型,那么该选择哪个呢?

这里讲一种简单粗暴的显存需求计算方法。例如,当模型精度为 FP4 时:

7B 模型的显存需求 = 7000000000 (参数数量) × 0.5 byte (4-bit) = 3500000000 byte / 1024 / 1024 / 1024 ≈ 3.26 GB 671B 模型的显存需求 = 671000000000 × 0.5 / 1024 / 1024 / 1024 ≈ 312.46 GB

当然,这些只是理论值。显存占用的大小不仅与模型的参数数量和大小有关,还与是否量化、精度(如 FP4、FP8、FP16、FP32)、User Prompt、Max Tokes、Context Length 等因素相关。例如,像 q4_K_M 这种量化模型,其显存占用会更低。因此,这只是一个估算值。在实际生产环境中,建议将理论值乘以 2 到 3 来预估显存需求。

以下是显存需求的大致参照表:

通过此表,可以帮助您快速选择适合自己需求的 DeepSeek R1 大模型。

推荐本站淘宝优惠价购买喜欢的宝贝:

本文链接:https://hqyman.cn/post/8950.html 非本站原创文章欢迎转载,原创文章需保留本站地址!

休息一下~~

微信支付宝扫一扫,打赏作者吧~

微信支付宝扫一扫,打赏作者吧~