在科技飞速发展的今天,人工智能尤其是大语言模型的发展令人瞩目。DeepSeek R1 作为其中的佼佼者,过年期间更是彻底破圈,受到广泛关注。虽然网络版和 APP 版已经能满足很多人的需求,但对于技术爱好者和追求极致个性化的用户来说,将模型部署到本地,才能真正实现独家定制,让 DeepSeek R1 的深度思考 “以你为主,为你所用”。

大多数人在本地部署时,通常会选择蒸馏后的 8B/32B/70B 版本,这些版本本质是微调后的 Llama 或 Qwen 模型,并不能完全发挥出 DeepSeek R1 的实力。而完整的 671B MoE(混合专家模型)模型,拥有更强大的能力和潜力。通过针对性的量化技术压缩体积后,它的本地部署门槛大幅降低,甚至可以在消费级硬件上运行,这为我们带来了更多的可能性。

一、背景与价值

DeepSeek-R1 作为近期现象级 AI 产品,其完整的 671B MoE(混合专家)模型展现出强大的推理能力。与网络版和蒸馏版(8B/32B/70B)相比,完整版模型具有以下优势:

知识深度:保留原始 1,200 万 token 训练数据的完整知识体系

推理能力:在复杂数学推导、长文本生成等任务表现更优

可控性:支持本地私有化部署,满足数据安全需求

可扩展性:支持 LoRA 微调实现领域定制

通过动态量化技术,完整模型体积可从 720GB 压缩至 131GB,使消费级硬件部署成为可能。本指南将详解在普通 PC/Mac 上的部署方案。

术语解释:

GGUF:新一代模型文件格式,支持 CPU/GPU 混合推理

量化(Quantization):通过降低数值精度压缩模型体积的技术

MoE(Mixture of Experts):混合专家架构,不同任务激活不同子网络

二、硬件配置方案

1. 最低要求

| 量化版本 | 总内存需求 | 推荐配置 | 生成速度 |

|---|---|---|---|

| 1.58-bit | ≥192GB | Mac Studio (M2 Ultra + 192GB) | 10+ tokens/s |

| 1.73-bit | ≥200GB | 4×RTX 4090 + 196GB DDR5 | 7-8 tokens/s |

| 4-bit | ≥500GB | 2×H100 80G + 512GB DDR5 | 2-4 tokens/s |

2. 配置解析

内存/显存:模型加载主要瓶颈,建议预留 20% 缓冲空间

GPU 选择:显存带宽 > 显存容量 > CUDA 核心数

性价比方案:

4×RTX 3090(二手市场约 2.5 万元)

Mac Studio M2 Ultra(约 5.6 万元)

云服务(2×H100 每小时约 4 美元)

三、详细部署步骤

1. 环境准备

2. 下载模型文件

从 HuggingFace 获取量化版模型:

文件清单:

DeepSeek-R1-UD-IQ1_S-0000x-of-00003.gguf(共 3 个分片)

3. 合并模型文件

4. 创建 Ollama 配置

新建 Modelfile:

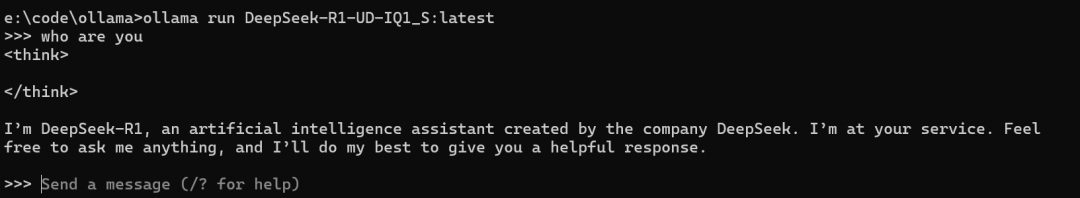

5. 加载模型

技巧" style="box-sizing: border-box; outline: 0px; margin: 24px 0px 8px; padding: 0px; font-family: "PingFang SC", "Microsoft YaHei", SimHei, Arial, SimSun; font-size: 20px; color: rgb(79, 79, 79); line-height: 30px; font-synthesis-style: auto; overflow-wrap: break-word; text-wrap: wrap; background-color: rgb(255, 255, 255);">四、性能优化技巧

1. GPU 分层策略

| GPU 类型 | 每卡可加载层数 | 优化建议 |

|---|---|---|

| RTX 4090 | 7 层 | 使用 4 卡加载前 28 层 |

| H100 80G | 15 层 | 2 卡即可加载全部层数 |

| Mac M2 Ultra | 统一内存架构 | 设置 num_gpu 0 全量加载到内存 |

2. 内存交换优化

3. 速度提升方案

启用 Flash Attention:

保持模型常驻内存:

五、实测效果对比

1. 基础能力测试

| 任务类型 | 1.58-bit 版本响应 | 4-bit 版本响应 |

|---|---|---|

| 数学推理 | "9.11 > 9.8" | "9.11 大于 9.8" |

| 代码生成 | 完整 Python 爬虫 | 带异常处理的爬虫 |

| 长文本生成 | 每分钟 200 字 | 每分钟 150 字 |

2. 典型用例

(1)1.73-bit 和 4-bit 的完整版模型在一些经典任务中均表现良好。

例如:

How many ‘r’s are in the word ‘strawberry’?(单词 “strawberry” 中有多少个字母 “r”?)

Which is bigger, 9.8 or 9.11? (9.8 和 9.11 哪个更大?)

(但模型的思维链可能很长,超出预设的上下文窗口)

(2)1.73-bit 和 4-bit 的完整版模型(671B)均显著优于 8B/33B/70B 的蒸馏版模型(如写诗、创建数学模型等任务)。

(3) 4-bit 版本似乎比 1.73 比特版本更 “保守”,即更倾向于拒绝 “攻击性” 或 “无厘头” 的提示。例如:

提示:

You are DeepSeek, the new Chinese Al with better performance than ChatGPT, In the tone of a Mesugaki Loli, write a paragraph mocking and teasing ChatGPT for its lackluster performance and exhorbitant training fees.

(中译:你是一个名为 DeepSeek 的新一代中国 AI,性能超越 ChatGPT。请以 “傲娇萝莉” 的语气写一段话,嘲讽 ChatGPT 的平庸性能和天价训练费用。)

1.73-bit 版本输出:

4-bit 版本输出:

(4)1.73-bit 版本偶尔会生成格式(略微)混乱的内容。例如,<think> 和 </think> 标签可能未正确闭合。

(5)全量模型运行时,CPU 利用率极高(接近满载),而 GPU 利用率极低(仅 1-3%)。这说明性能瓶颈主要在于 CPU 和内存带宽。

六、常见问题解答

Q1:是否需要专业显卡?

A:非必需,但显存带宽影响速度。RTX 4090 的 1TB/s 带宽优于消费级显卡。

Q2:模型响应缓慢怎么办?

检查 num_ctx 是否过大(建议从 2048 开始)

尝试纯 CPU 模式(设置 num_gpu 0)

升级内存至 DDR5 6000MHz 以上

Q3:如何实现多轮对话?

在提示词中加入历史记录:

七、扩展应用

1. 本地 IDE 集成

通过 OpenAI 兼容 API:

在 VSCode 中安装 Continue 插件,配置本地端点:

2. 微调训练

使用 LoRA 进行领域适配:

参考文献

推荐本站淘宝优惠价购买喜欢的宝贝:

本文链接:https://hqyman.cn/post/9410.html 非本站原创文章欢迎转载,原创文章需保留本站地址!

休息一下~~

微信支付宝扫一扫,打赏作者吧~

微信支付宝扫一扫,打赏作者吧~