引言

随着deepseek的开源,大家都在争先恐后的往AI发展和研究。所以最近也开始陆续部署了各种框架,各种尝试,也踩过了很多坑。此篇文章主要讲ollama部署过程,都以经过验证。

部署建议

1、系统:优先选择win、其次ubuntu、最后mac和linux

2、魔法:最好有

为什么优先选择win,主要就是安装最简单,而且魔法环境配置容易。选择其他系统时,比如linux,有时候下载模型是很费劲的,需要掌握更多的底层网络知识,命令行安装代理较为麻烦。

如果有软路由是最好的,那么所有系统下,安装或拉模型都没有什么太大问题。

配置准备

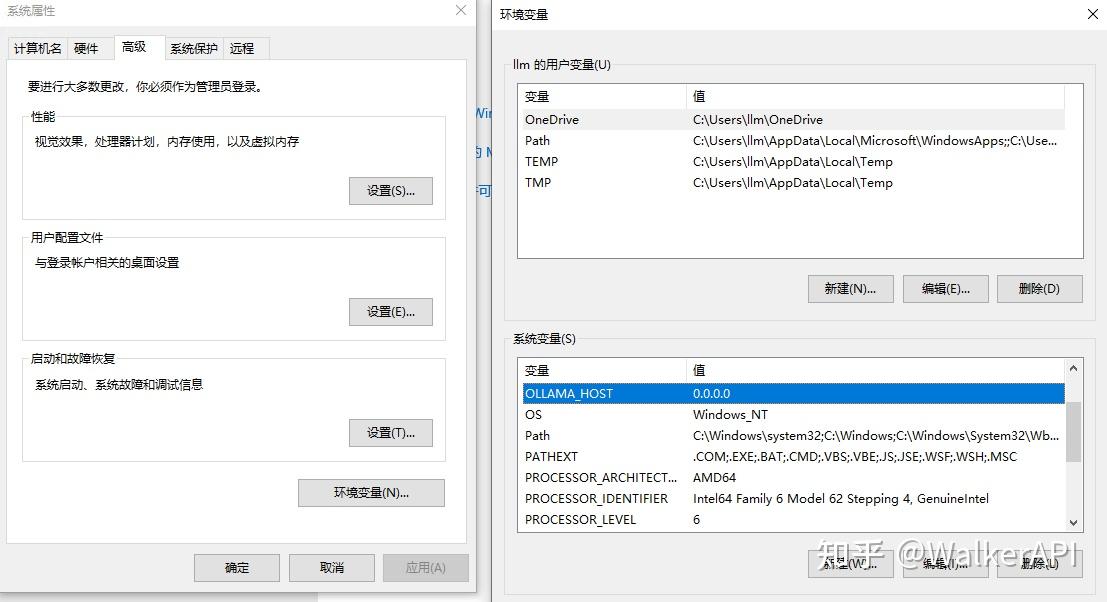

ollama最主要的是两个环境变量:

OLLAMA_MODELS:指定下载模型的存放路径,不设置将会放在默认目录,例如C盘。

OLLAMA_HOST:指定ollama运行时绑定ip,不设置只能本地访问。

这里稍微解释一下OLLAMA_HOST,默认他绑定的是127.0.0.1,也就是说只能自身访问。当其他网络设备想要调用时就不通了。所以是推荐直接修改为0.0.0.0,允许所有设备访问。

Win配置很简单,只需要在环境变量里加入即可,直接接入系统变量,所有用户都生效。

linux系的稍微麻烦点,直接加环境变量可能无法生效,所以后面再说。

安装部署

直接访问地址,选择对应版本下载安装即可,win直接下一步下一步:

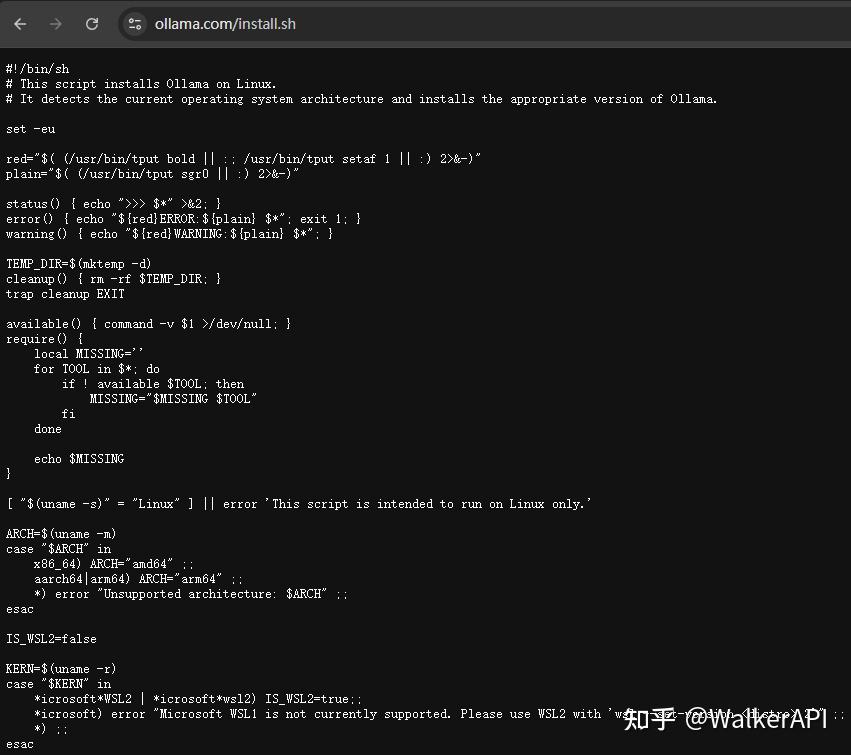

麻烦点的就还是linux的安装,需要执行以下命令:

curl -fsSL https://ollama.com/install.sh | sh执行完后其实就可以自动安装的,但前提是魔法没问题。

如果依然无法正常安装,建议是直接下载脚本到linux上,自己手动安装下

直接把install.sh丢到linux上

授权执行:chmod +x install.sh

最后运行:./install.sh

如果还不能安装,则还是需要魔法,如果没有软路由的情况,可以用 proxychains4,(需要单独安装)这样的软件来进行代理。

直接执行 proxychains4 ./install.sh 即可。

安装完毕后会生成 ollama.service 服务文件,刚才上面说到的linux环境变量配置,咱们把他配置到 ollama.service里:

[Unit]Description=Ollama ServiceAfter=network-online.target[Service]ExecStart=/usr/local/bin/ollama serveUser=ollamaGroup=ollamaRestart=alwaysRestartSec=3Environment="OLLAMA_MODELS=/data/ollama/models"Environment="OLLAMA_HOST=0.0.0.0"[Install]WantedBy=default.target直接删除Environment原有的内容,不要在后面或者前面加,非常容易报错。就按照我上面的写就行,写两个Environment保存即可。

如果OLLAMA_MODELS不需要变更,就直加一个 Environment="OLLAMA_HOST=0.0.0.0" 就可以。

最后重新加载配置文件,重启服务

systemctl daemon-reload

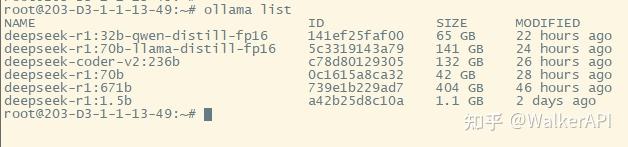

systemctl restart ollama到此win和linux的就都安装完毕了,镜像就直接pull就好

推荐本站淘宝优惠价购买喜欢的宝贝:

本文链接:https://hqyman.cn/post/9524.html 非本站原创文章欢迎转载,原创文章需保留本站地址!

休息一下~~

微信支付宝扫一扫,打赏作者吧~

微信支付宝扫一扫,打赏作者吧~