1、先安装我们的ollama

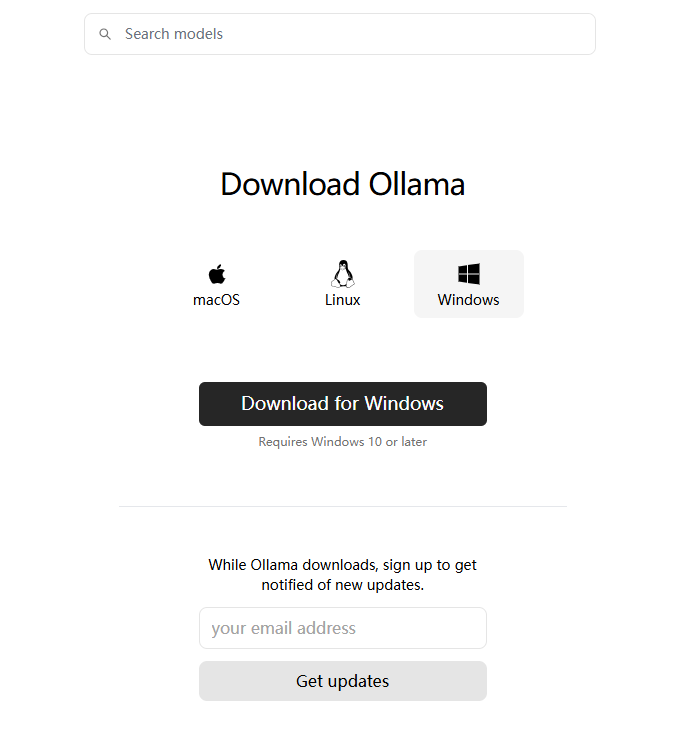

1.1、官网地址:https://ollama.com/

选择合适的版本,我的是window版本,点击下载,不用填邮箱。

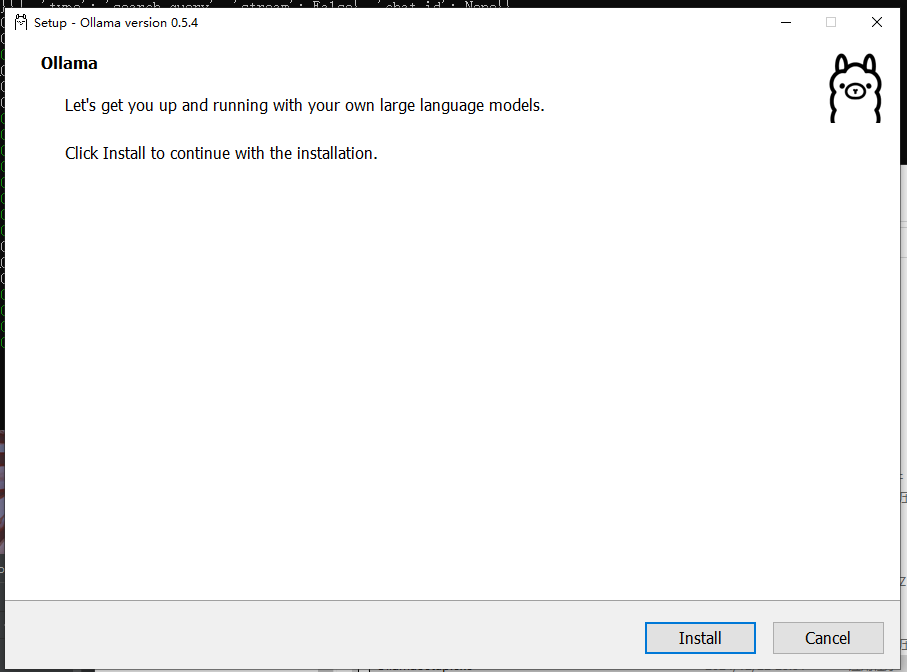

1.2、开始安装,选择默认就可以

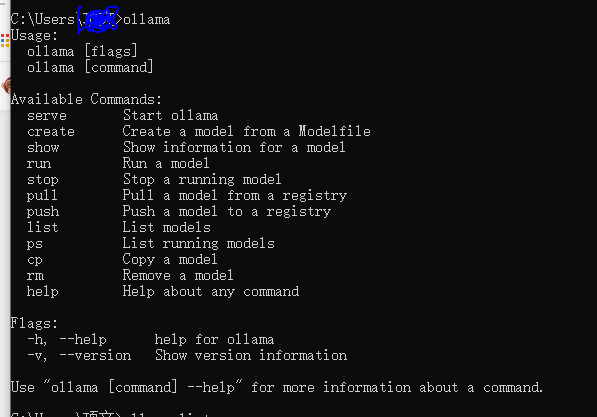

1.3、安装完毕:cmd输入:ollama

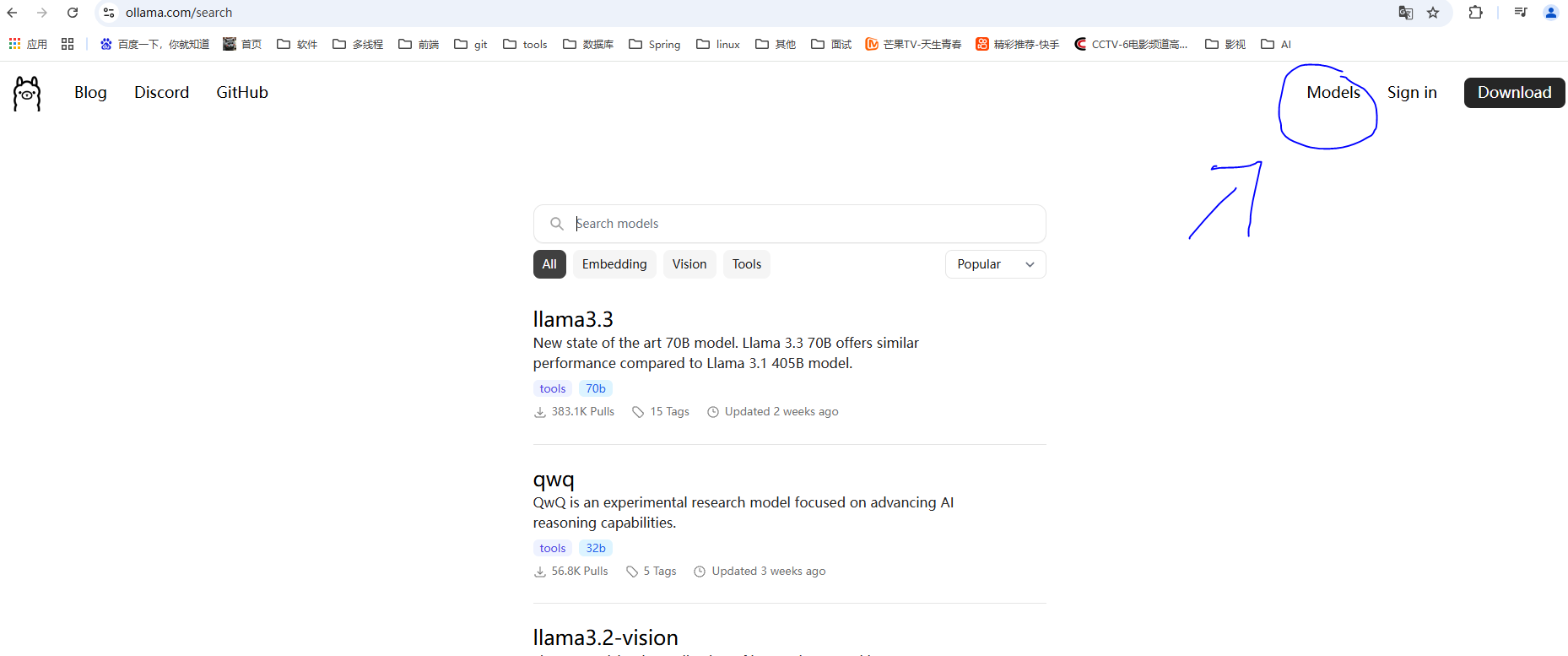

2、安装模型:llama3.1

2.1:找到模型

2.2复制下载

2.3、命令行下载:

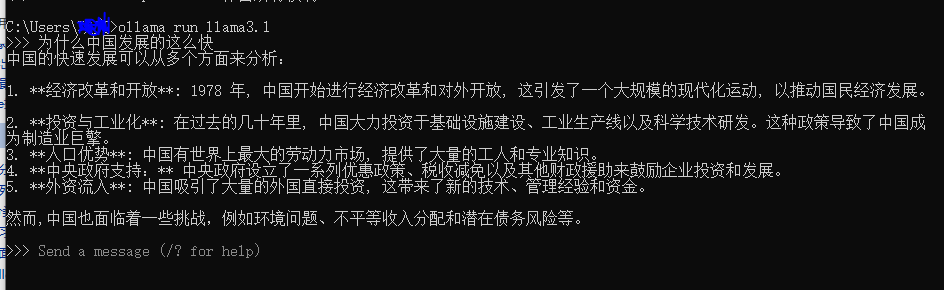

2.4、下载完毕就进入对话界面了:

到这本地模型已经搭建起来了,加个页面的话openweb-ui会看着舒服点

3、使用pip命令安装openweb-ui

由于我的电脑是win10家庭版,安装不了docker,看了好多方式是使用docker安装openwenb-ui,不过通过pip命令安装也是一样的

不过要保证python命令在3.11.0到3.12.0之间的版本

3.1 换源

pip config set global.index-url https://mirrors.aliyun.com/pypi/simple

3.2、安装

pip install open-webui

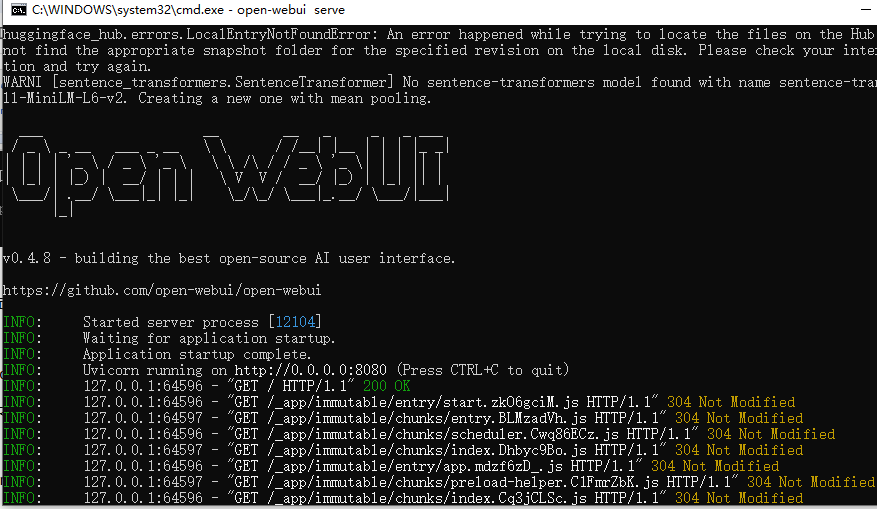

3.3、运行,出现logo则成功了

open-webui serve

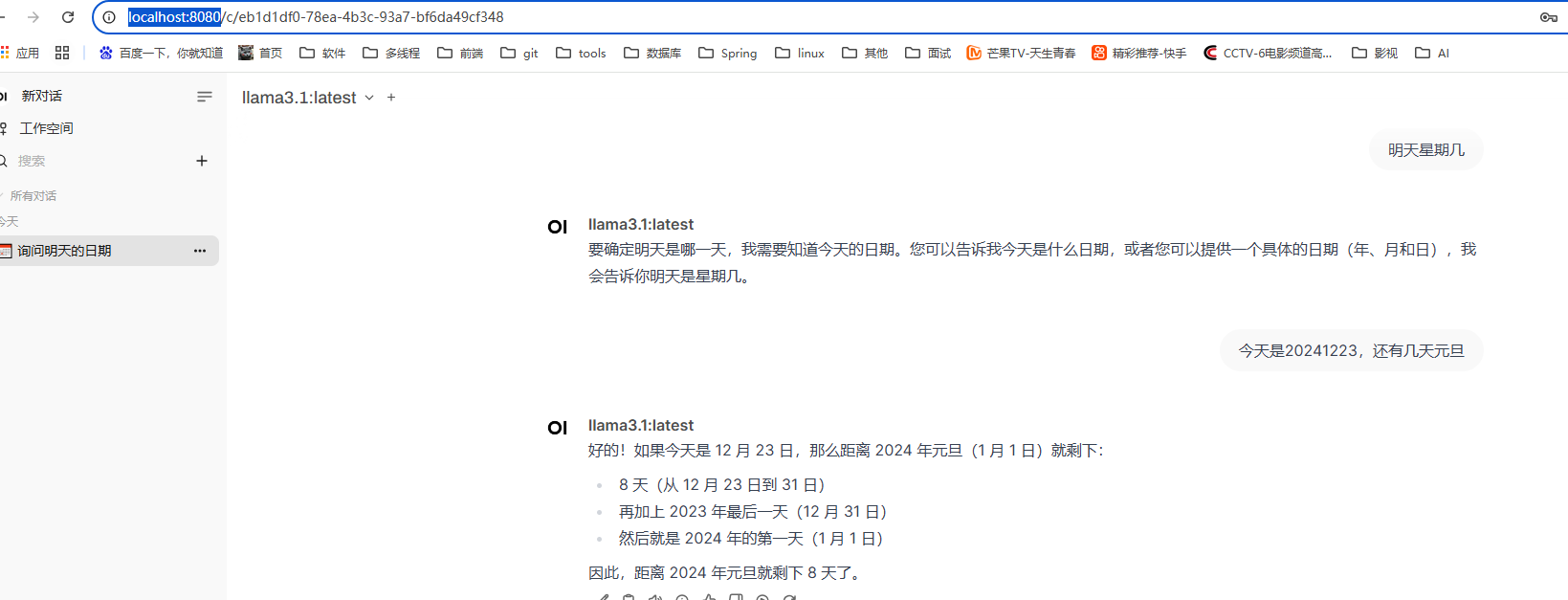

3.4、访问本地:http://localhost:8080/

第一个用户密码将作为超级管理员

推荐本站淘宝优惠价购买喜欢的宝贝:

本文链接:https://hqyman.cn/post/9539.html 非本站原创文章欢迎转载,原创文章需保留本站地址!

休息一下~~

微信支付宝扫一扫,打赏作者吧~

微信支付宝扫一扫,打赏作者吧~