Python 3.11:这是必须严格使用的版本,更高版本可能会出现不兼容问题。可访问Python 官网下载 Python 3.11.9 安装包,安装时务必勾选 “Add Python 3.11 to PATH”,安装完成后在命令行输入python --version验证,出现版本信息即安装成功。

Node.js 20.x 及以上:用于前端依赖管理。从Node.js 中文网下载最新 LTS 版本(如 20.12.2),安装完成后在命令行输入node -v && npm -v验证。

Ollama:若要使用 Ollama 模型,需提前安装并运行 Ollama。安装教程可参考相关文章 。

启动 Open WebUI:在 cmd 窗口输入open-webui serve 。

访问 Open WebUI:启动后,在浏览器输入默认访问地址:http://localhost:8080 。若需自定义数据存储路径,可在相关设置中进行调整。

设置中文界面:登录后,在右上角设置中选择 “简体中文”,提升使用体验。

选择模型:进入网站后,在右上角选择本地已安装的大模型,如 deepseek - r1.5 等,选择之后就可以进行对话了。

模型文件存储路径优化:通过环境变量OLLAMA_MODELS将模型文件迁移至非系统盘(如D:\ollama_models),避免 C 盘空间被大量占用。

端口冲突处理:若 8080 端口被占用,可通过--port参数指定其他端口,如open-webui serve --port 8090 。

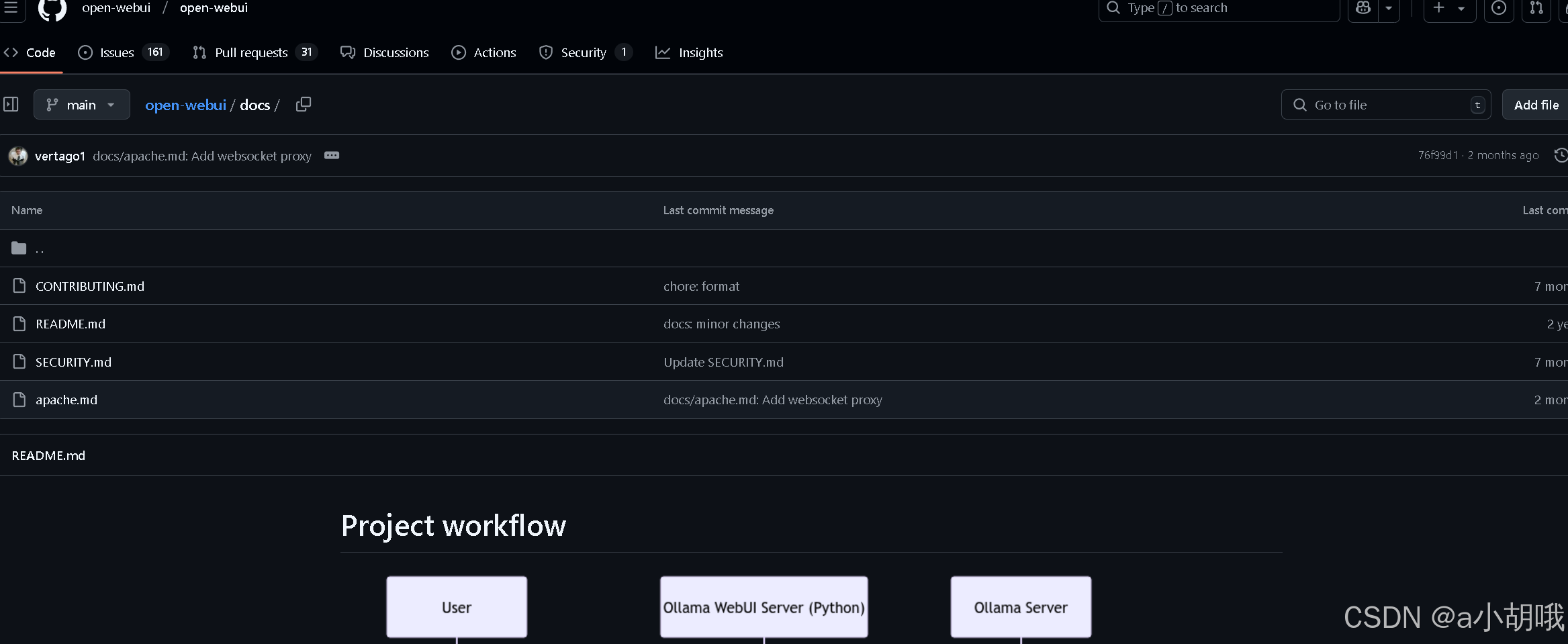

Docker 安装:推荐使用带有:cuda或:ollama标签的官方镜像。需根据 Ollama 是否在本地以及是否需要 GPU 支持选择不同的命令,关键是要挂载数据卷-v open - webui:/app/backend/data以防止数据丢失,具体命令可参考GitHub 页面中的详细说明。如果 Ollama 在不同的服务器上,需要设置OLLAMA_BASE_URL环境变量。

Docker Compose、Kustomize 和 Helm 安装:更多安装方法可参考Open WebUI 文档。

推荐本站淘宝优惠价购买喜欢的宝贝:

本文链接:https://hqyman.cn/post/9548.html 非本站原创文章欢迎转载,原创文章需保留本站地址!

休息一下~~

微信支付宝扫一扫,打赏作者吧~

微信支付宝扫一扫,打赏作者吧~