#安装脚本,这里用的是复制避免使用mv 用户找不到,

#!/bin/bash

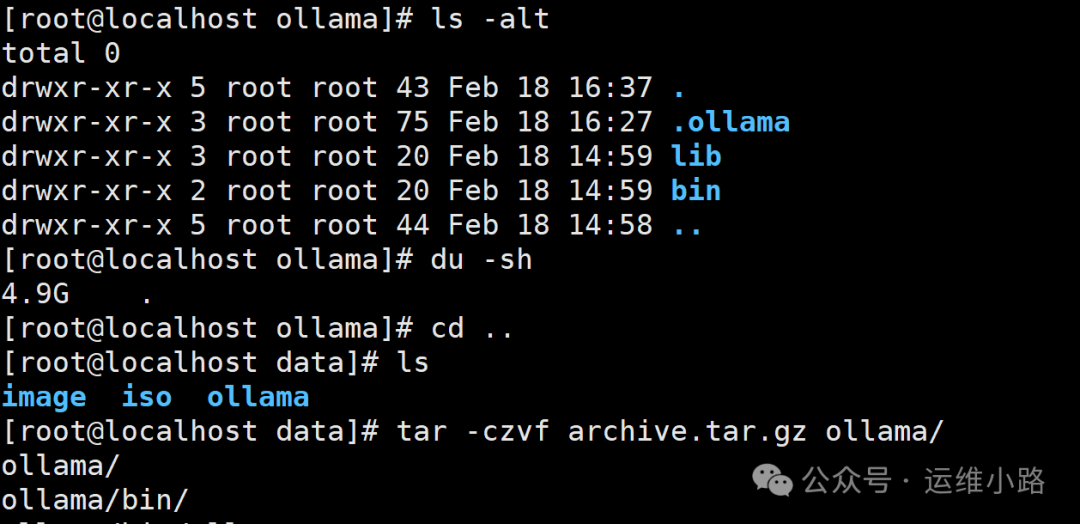

tar xvf ollama.tar.gz

cd ollama

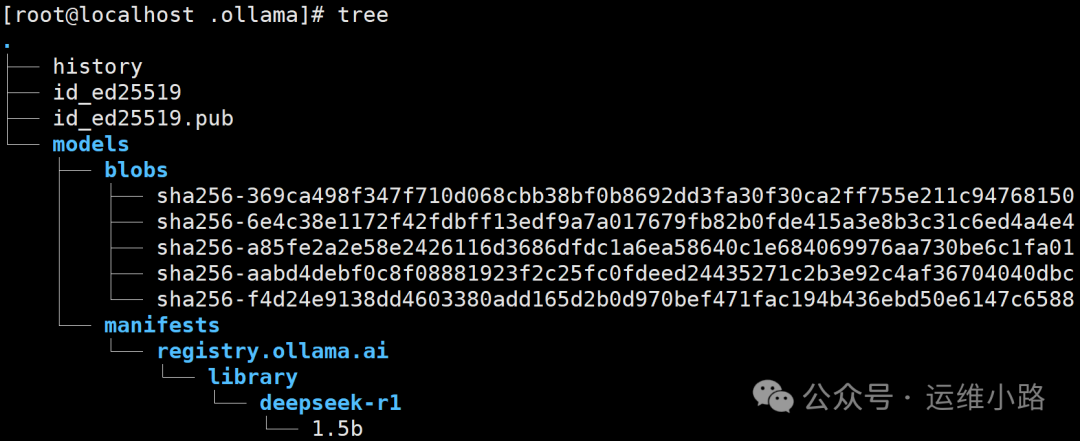

cp -r .ollama /root/

推荐本站淘宝优惠价购买喜欢的宝贝:

本文链接:https://hqyman.cn/post/9757.html 非本站原创文章欢迎转载,原创文章需保留本站地址!

休息一下~~

HQY 一个和谐有爱的空间

HQY 一个和谐有爱的空间

#安装脚本,这里用的是复制避免使用mv 用户找不到,

#!/bin/bash

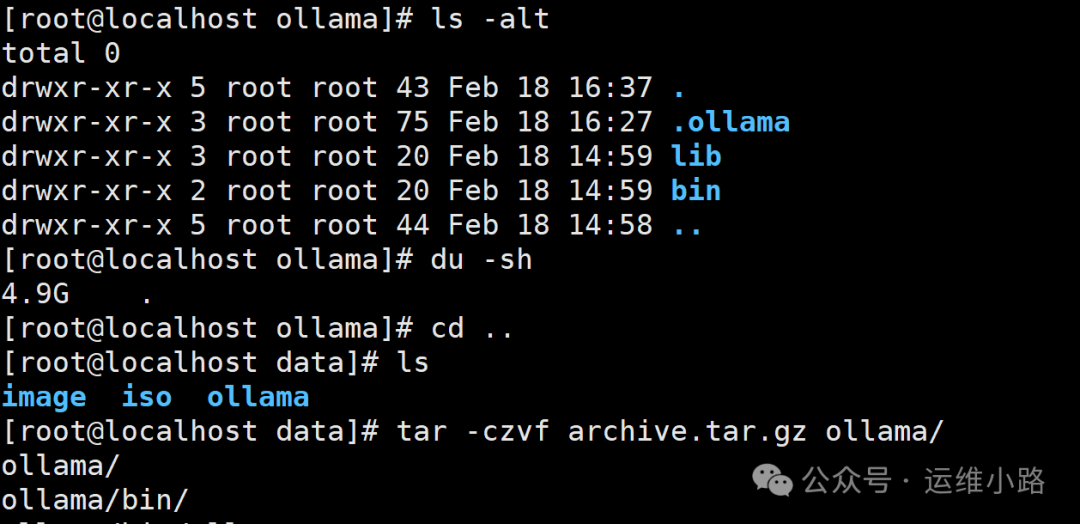

tar xvf ollama.tar.gz

cd ollama

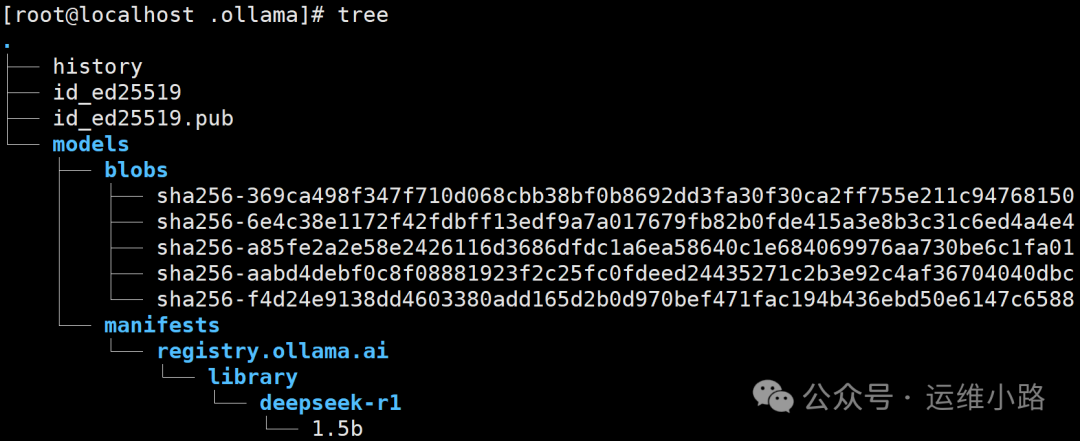

cp -r .ollama /root/

推荐本站淘宝优惠价购买喜欢的宝贝:

本文链接:https://hqyman.cn/post/9757.html 非本站原创文章欢迎转载,原创文章需保留本站地址!

休息一下~~

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。

您的IP地址是: