DeepSeek本地部署详细指南

随着人工智能Q技术的飞速发展,本地部署大模型的需求也日益增加。DeepSeek作为一款开源且性能强大的大语言模型,提供了灵活的本地部署方案,让用户能够在本地环境中高效运行模型,同时保护数据隐私。以下是详细的DeepSeek本地部署流程。

DeepSeek本地自动部署(懒人专用)

DeepSeek作为目前热门的AI工具,相信很多人都想体验一下它的智能服务。DS大模型安装助手就是为了给用户提供一个无延迟,无卡顿的流畅DeepSeek。

第一步:下载安装DS大模型安装助手

https://file-cdn-deepseek.fanqiesoft.cn/deepseek/deepseek_28315_st.exe

第二步:打开软件,根据推荐选择适配模型,点击“自动部署”

第三步:等待模型下载,下载完成后可在下载中心查看。

第四步:点击“立即部署”,弹出弹窗后等待部署完成

第五步:部署完成后在弹出的界面中就可以直接使用了

DeepSeek手动部署

1、环境准备

(一)硬件需求

最低配置:CPU(支持AVX2指令集)+16GB内存+30GB存储。

推荐配置:NVIDIA GPU(RTX 3090或更高)+32GB内存+50GB存储

(二)软件依赖

操作系统:Windows、macOS或Linux。

Docker:如果使用Open WebUl,需要安装Docker.

2、安装Ollama

https://ollama.com/

Olama是一个开源工具,用于在本地轻松运行和部署大型语言模型。

以下是安装Ollama的步骤:

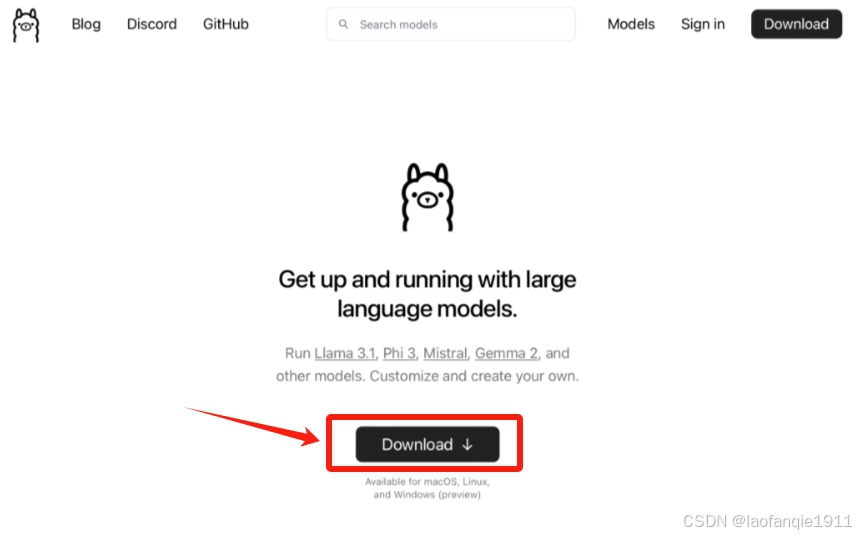

访问Ollama官网

前往Olama官网,点击“Download”按钮。

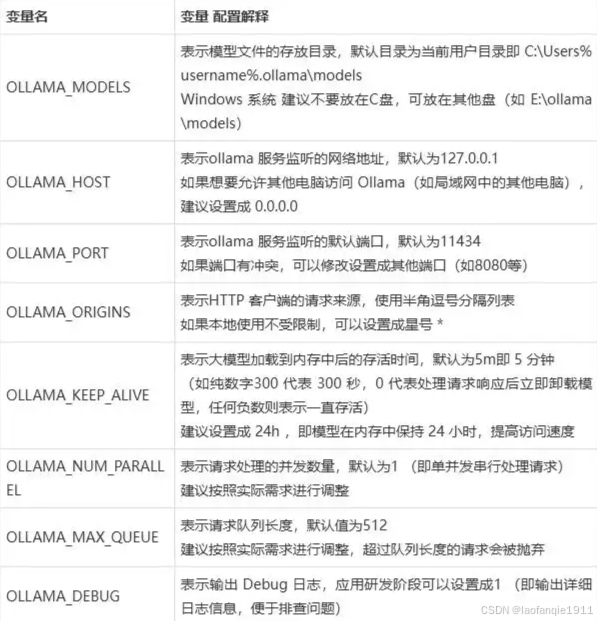

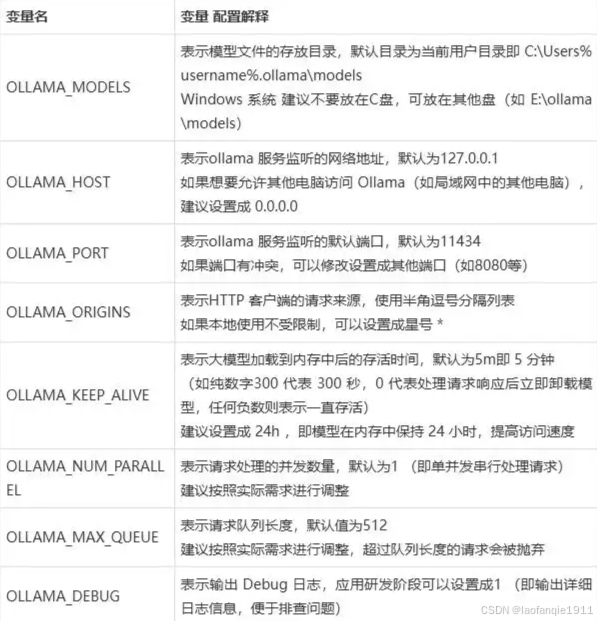

3、Ollama配置环境变量

Win10或Win11可以直接搜索“环境变量”,下图搜索,打开“编辑系统环境变量”设置:

具体配置环境变量解释如下图:

4、下载并部署DeepSeek模型

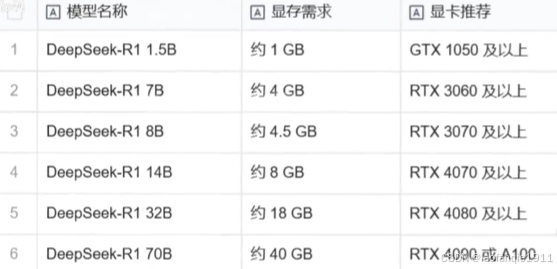

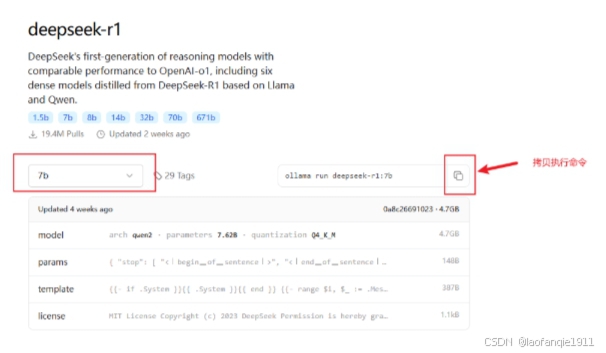

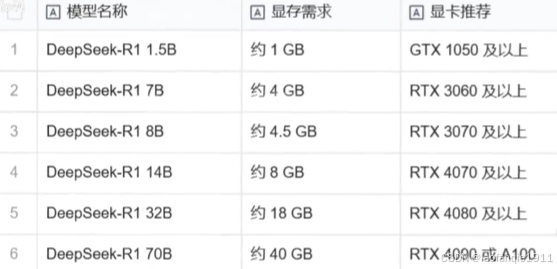

Ollama支持多种DeepSeek模型版本,用户可以根据硬件配置选择合适的模型。以下是部署步骤

选择模型版本:

入门级:1.5B版本,适合初步测试。

中端:7B或8B版本,适合大多数消费级GPU

高性能:14B、32B或70B版本,适合高端GPU。

下载模型:

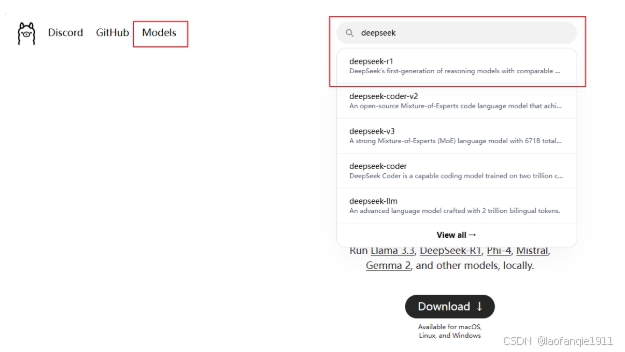

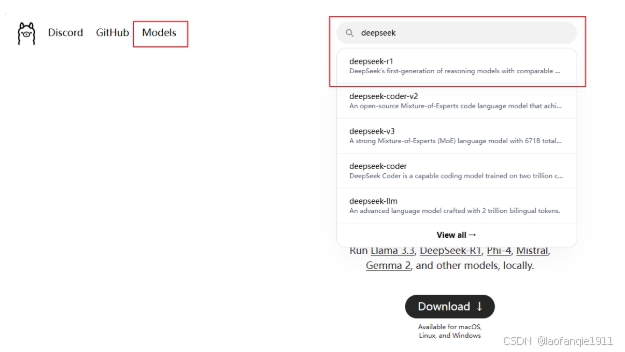

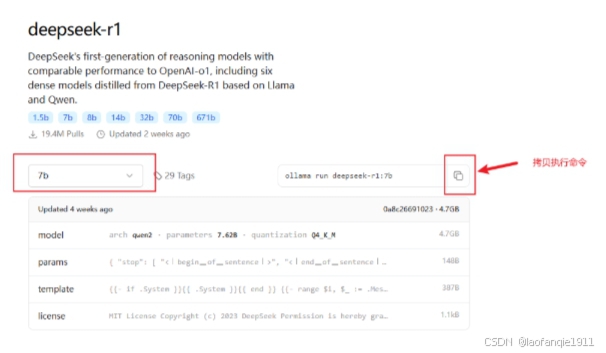

去Ollama官网点击Models进入模型选择:

在终端运行以下命令启动Ollama服务:

5、可视化图文交互界面 Chatbox

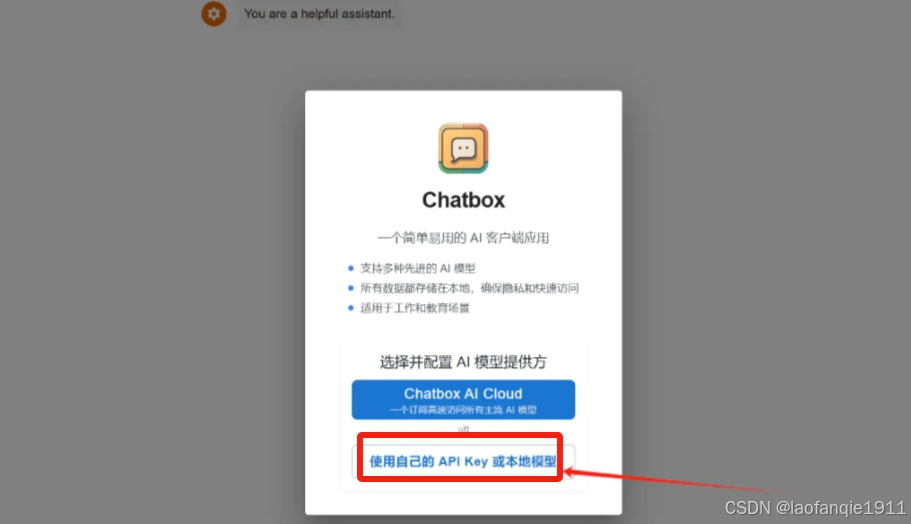

虽然我们可以在本地正常使用 Deepseek 这个模型了,但是这个 AI 工具的面板是非常简陋的,很多人使用不习惯,这时我们就可以通过 Chatbox 这个可视化图文交互界面来使用它。

免费下载" style="box-sizing: border-box; outline: none; margin: 0px; padding: 0px; text-decoration-line: none; cursor: pointer; color: rgb(78, 161, 219); font-synthesis-style: auto; overflow-wrap: break-word;">Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载

免费下载" style="box-sizing: border-box; outline: none; margin: 0px; padding: 0px; text-decoration-line: none; cursor: pointer; color: rgb(78, 161, 219); font-synthesis-style: auto; overflow-wrap: break-word;">Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载

进入 Chatbox 官网,Chatbox 虽然有本地客户端,但我们也可以直接使用网页版。

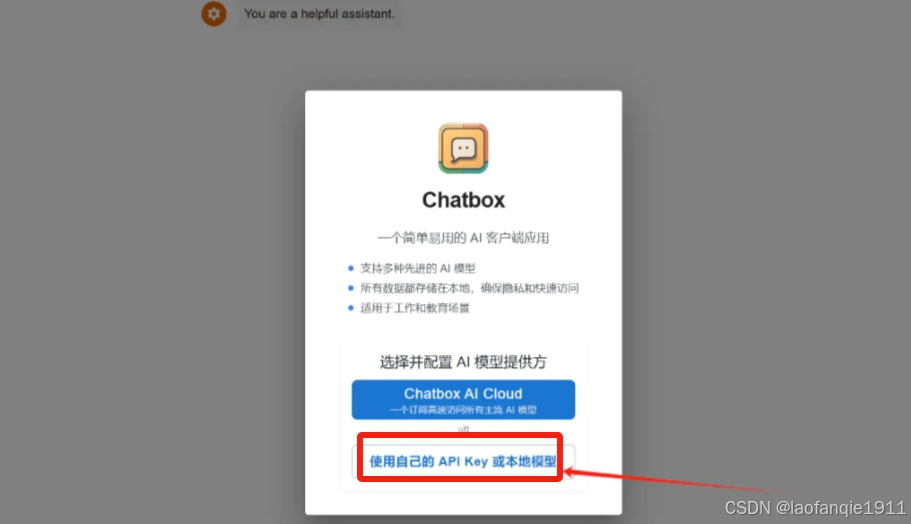

进入 Chatbox 网页版本后点击使用自己的 API Key 或本地模型。

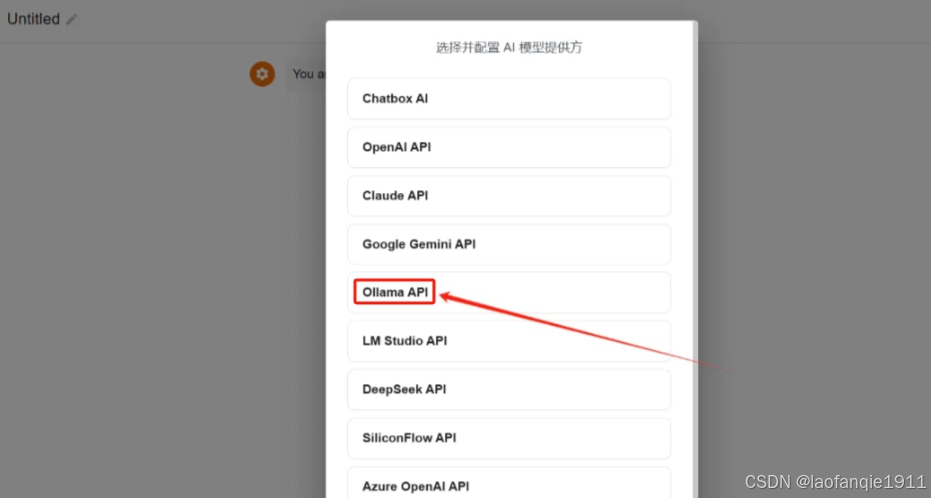

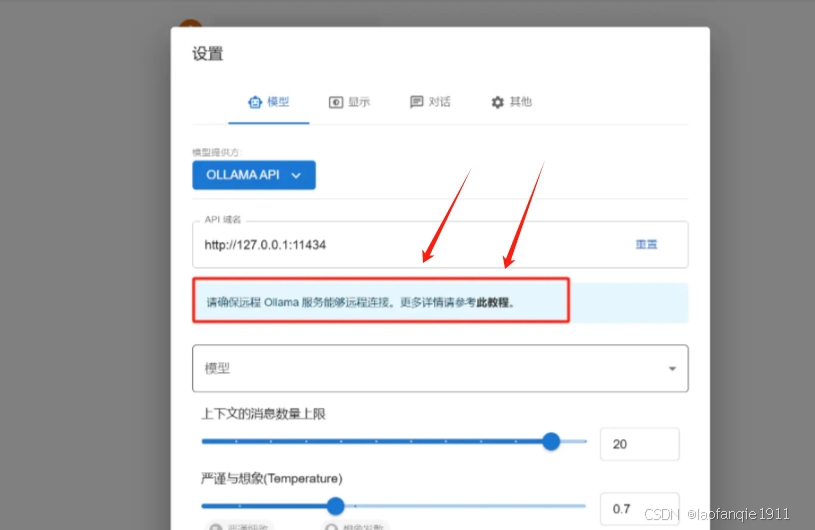

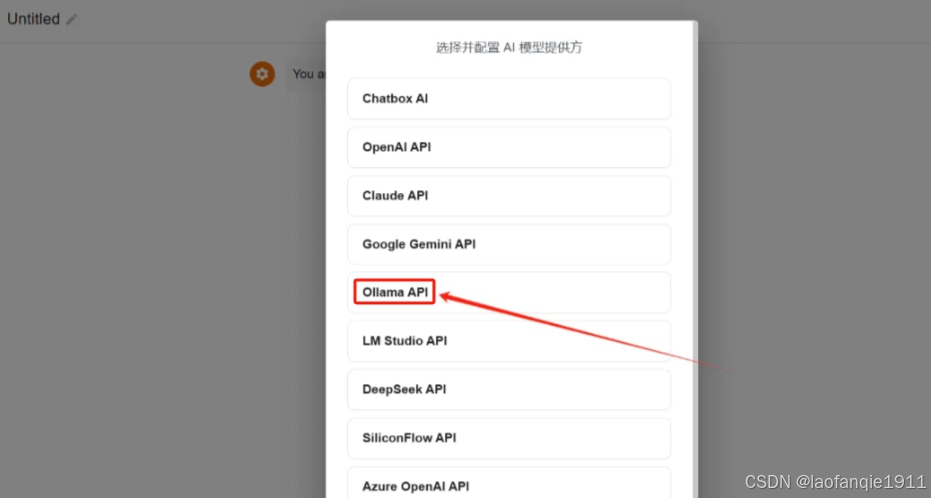

点击后会进入模型提供方选择界面,这里选择 Ollama API 。

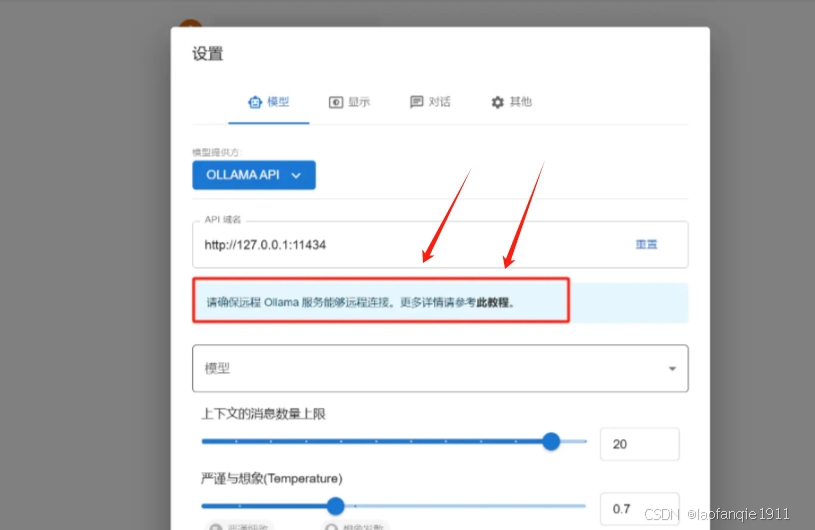

这里需要注意的是,为了能够 Ollama 能远程链接,这里我们最好看一下 Chatbox 提供的教程,根据这个教程操作一下。

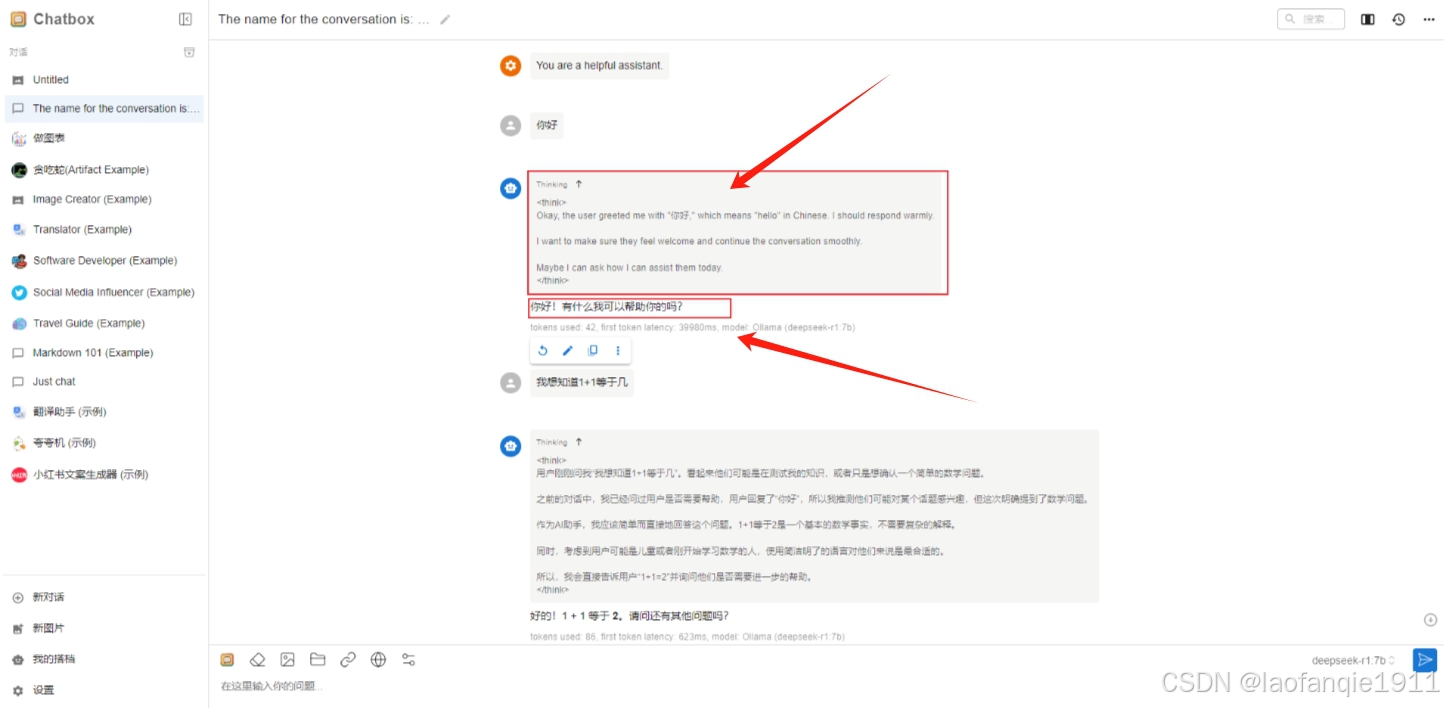

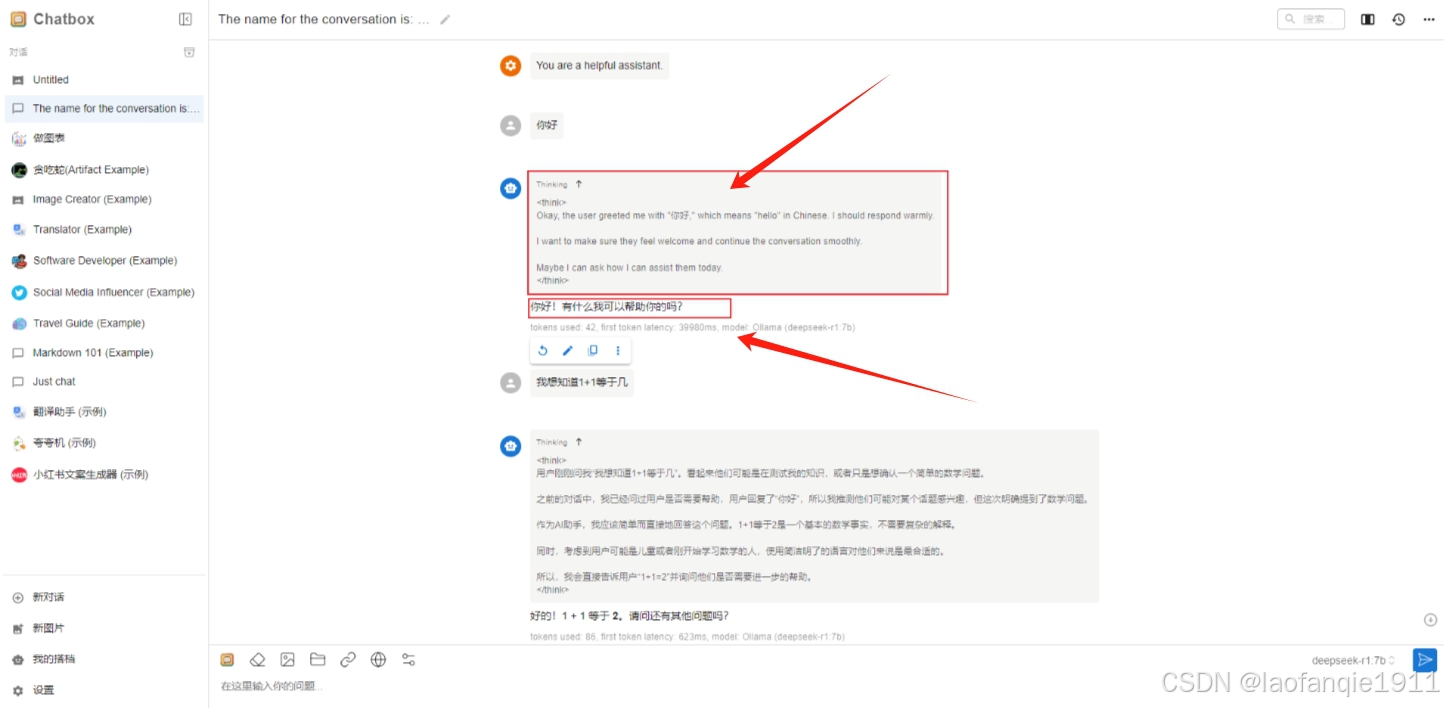

接下来只需要在 Chatbox 中新建对话即可使用 Deepseek 模型了,以下图为例,上方是它的思考过程,下方是它给出的答案。

到此我们可以使用自己的大模型了。

推荐本站淘宝优惠价购买喜欢的宝贝:

本文链接:https://hqyman.cn/post/10512.html 非本站原创文章欢迎转载,原创文章需保留本站地址!

打赏

微信支付宝扫一扫,打赏作者吧~

休息一下~~

微信支付宝扫一扫,打赏作者吧~

微信支付宝扫一扫,打赏作者吧~